Willkommen bei Krake.

Optimale Verteilung von Arbeitslasten anhand individueller Metriken.

Auf Open-Source-Basis.

Auf Open-Source-Basis.

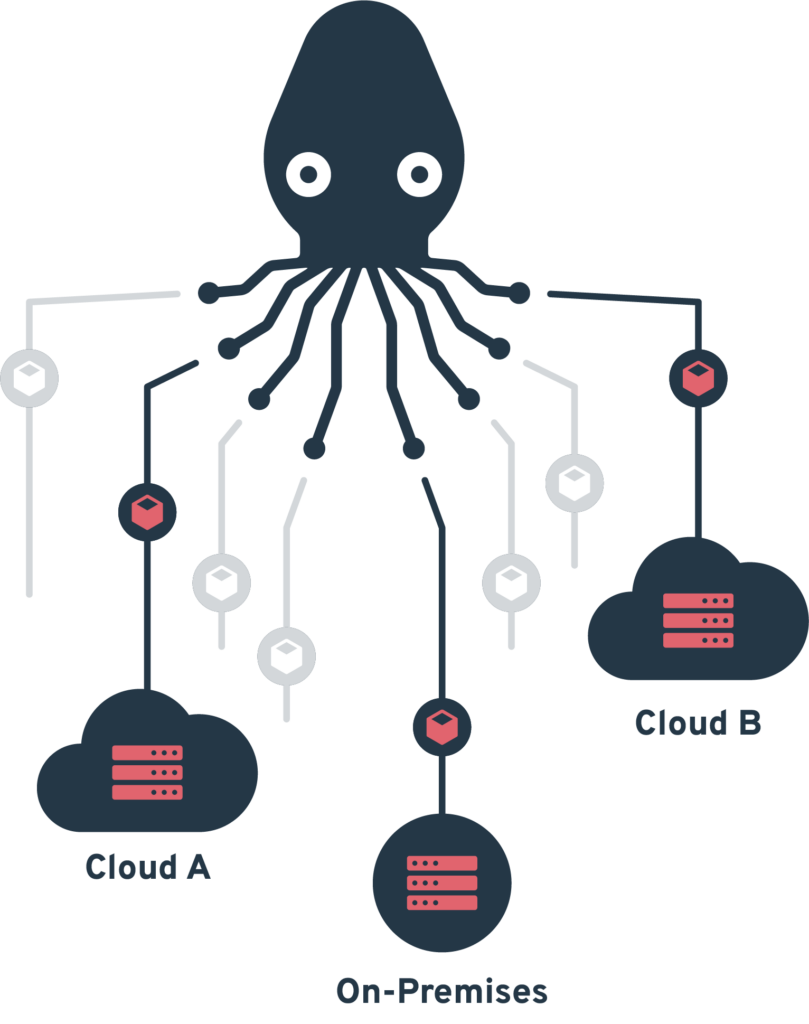

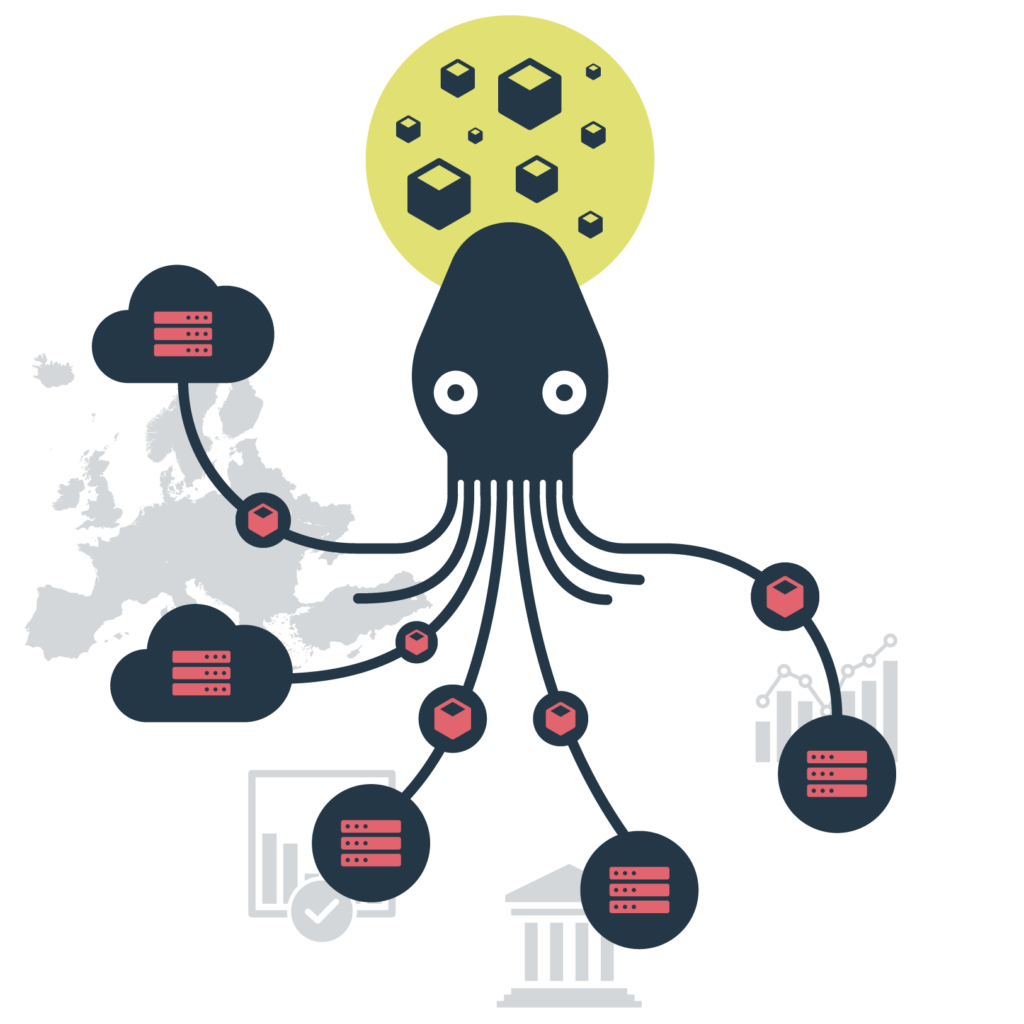

Ob Multi-Cloud, Private Cloud, oder On-Premise: In einer verteilten digitalen Infrastruktur ermöglicht der Open-Source-basierte Workload-Manager Krake [ˈkʀaːkə] die effiziente Verteilung virtualisierter und containerisierter Arbeitslasten hin zu jenen Ausführungsorten, die unter ökologischen, technischen oder wirtschaftlichen Gesichtspunkten optimal sind. Die entsprechenden Metriken sind vom Nutzer dabei frei wähl- und konfigurierbar.

Die Verwaltung containerisierter Anwendungen auf verteilten Infrastrukturen erfordert intelligente Orchestrierung – basierend auf verschiedenen Metriken und mit minimalem Verwaltungsaufwand.

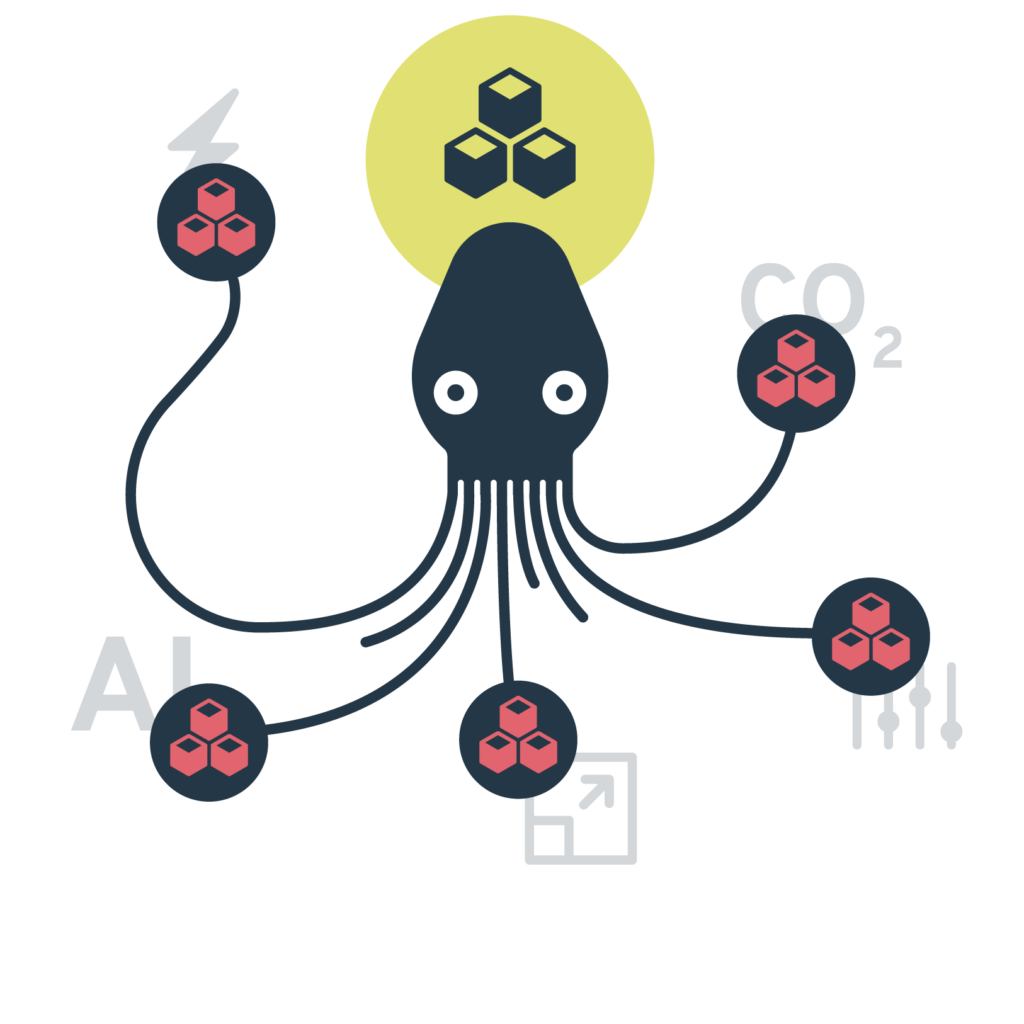

Rechenintensive Workloads, insbesondere KI-Anwendungen, verursachen hohe Energiekosten und CO₂-Emissionen – von Entwicklungsumgebungen bis zu geschäftskritischen Produktivsystemen.

Krake orchestriert Container-Workloads über eine einheitliche Schnittstelle auf verteilten Kubernetes-Clustern – standortübergreifend und automatisiert.

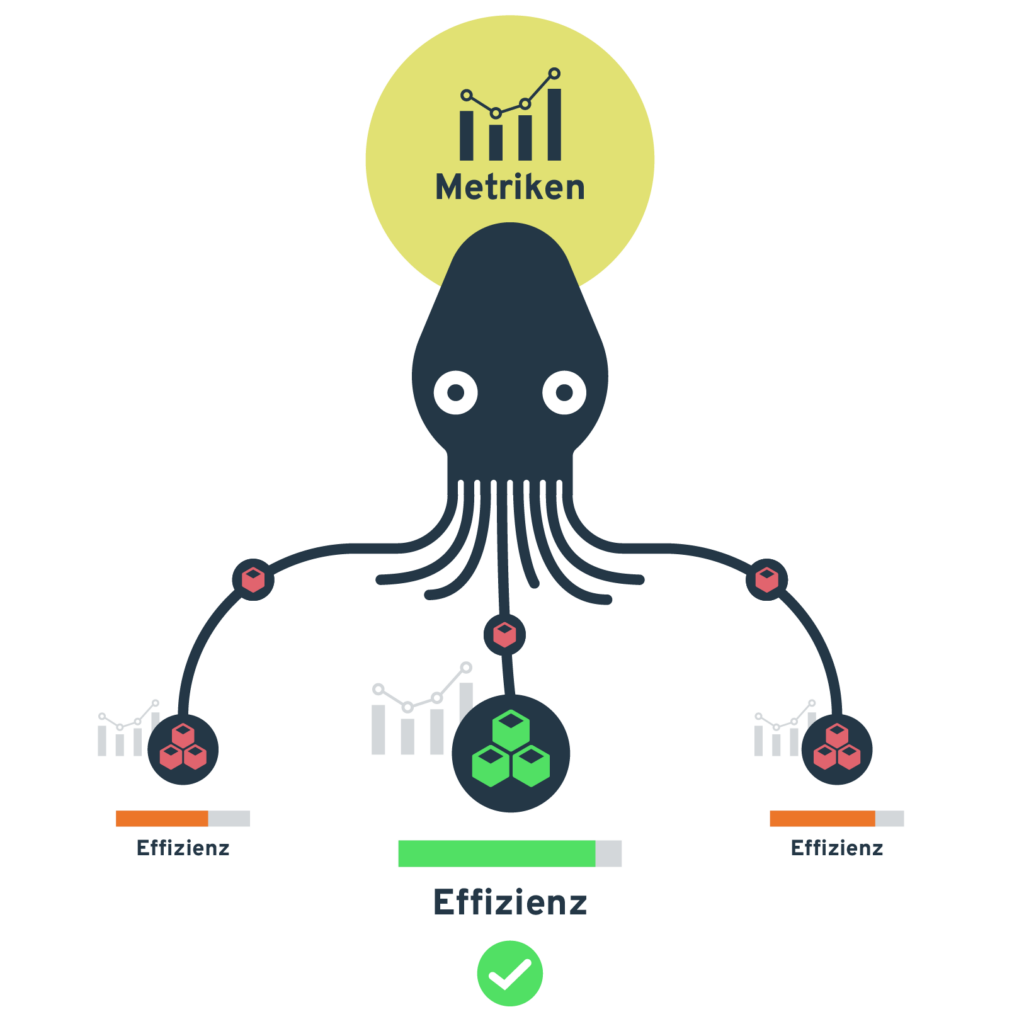

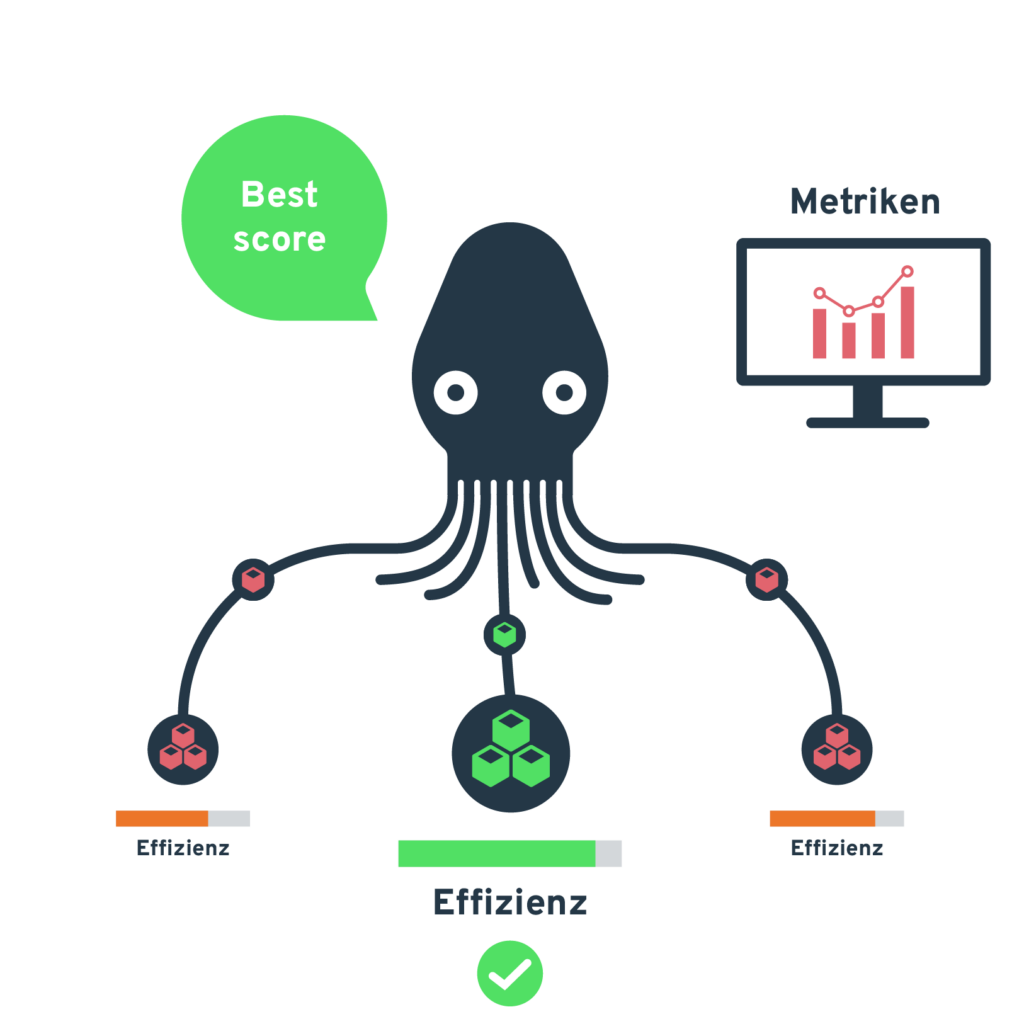

Nutzer definieren individuelle Metriken für die Workload-Verteilung: Performance, Kosten, Energieeffizienz und Sicherheitsanforderungen werden in Echtzeit berücksichtigt.

Von lokalen Entwicklungsumgebungen bis zu geografisch verteilten Produktivsystemen – Krake optimiert Container-Workloads jeder Größenordnung, von Microservices bis zu KI-Trainingsumgebungen.

Einheitliche Schnittstelle zur Verwaltung verteilter Kubernetes-Cluster über eine zentrale Abstraktionsebene.

Mikroservice-basierte Komponenten ermöglichen flexible Anpassung und Integration eigener Entwicklungen in die Orchestrierungs-Pipeline.

Orchestrierung von Kubernetes-Workloads über verschiedene Cluster und Standorte hinweg.

Automatisierte Container-Workload-Verteilung basierend auf konfigurierbaren Metriken wie Latenz, Energie und Kosten und nutzerdefinierten Parametern.

Feingranulare Kontrolle der Workload-Verteilung durch benutzerdefinierte Labels und Constraints.

Orchestrierung sowohl zustandsloser als auch zustandsbehafteter Container-Anwendungen – von Microservices bis zu komplexen Datenbanksystemen.

Automatisierte Bereitstellung und Skalierung von Kubernetes-Clustern über verschiedene Infrastruktur-Provider.

Krake ist vollständig quelloffen und ermöglicht Zusammenarbeit und Transparenz bei jedem Schritt.

Definiere deine individuellen Metriken und Metrics Provider (z.B. Prometheus). Diese bestimmen, nach welchen Kriterien Krake deine Workloadplatzierung optimiert.

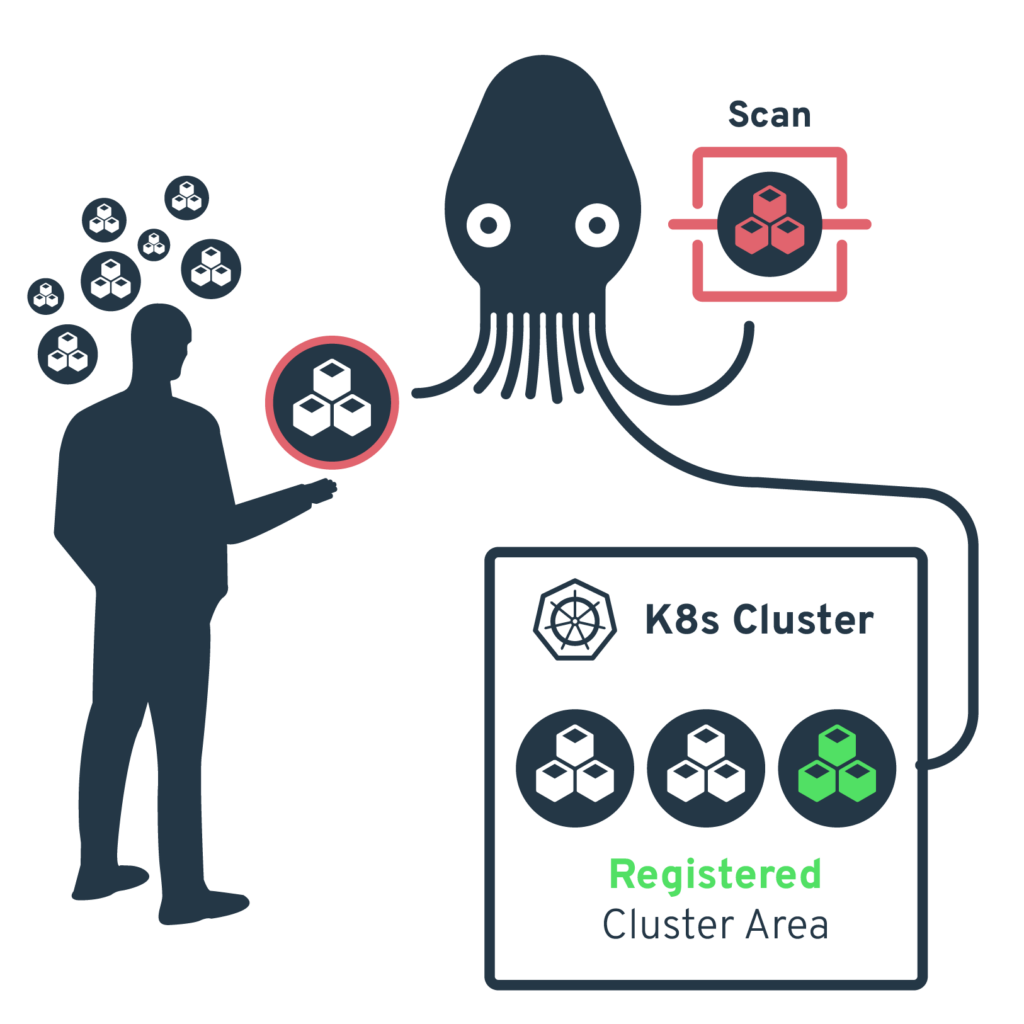

Registriere deine Kubernetes-Cluster bei Krake. Die Cluster können sowohl lokal als auch in der Cloud betrieben werden.

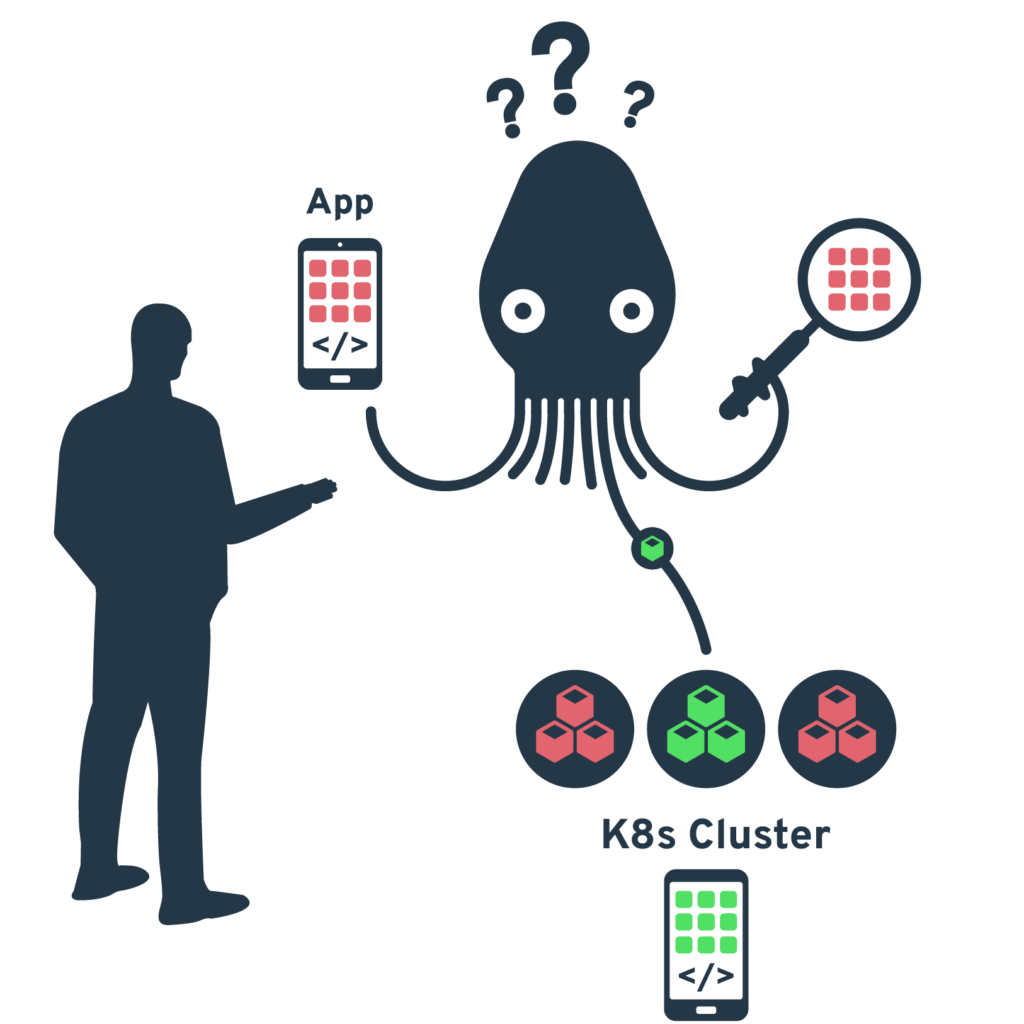

Rollout deiner containerisierten Anwendungen. Krake analysiert die definierten Metriken und platziert die Workloads automatisch auf den am besten geeigneten Clustern.

Krake überwacht kontinuierlich die Metriken und passt die Platzierung der Workloads bei Bedarf automatisch an – für optimale Performance und Ressourcennutzung.

Effiziente Ressourcennutzung im lokalen Rechenzentrum

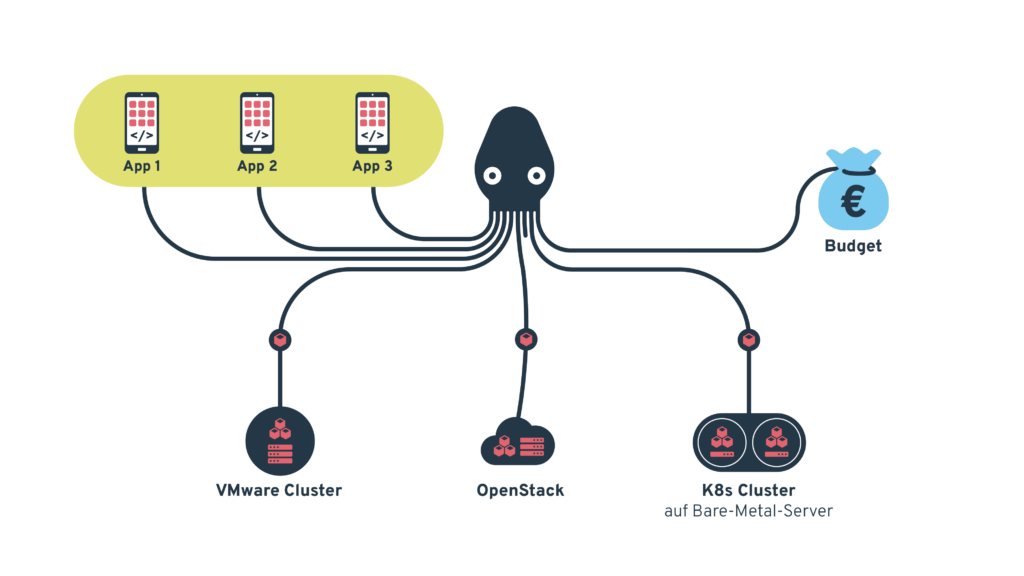

Ein mittelständisches Softwareunternehmen nutzt Krake zur Integration seiner heterogenen IT-Infrastruktur, bestehend aus einem klassischen VMware-Cluster, zwei Kubernetes-Clustern auf Bare-Metal-Servern und einer OpenStack-Installation. Damit Krake tätig werden kann, werden das VMware Cluster wie auch das OpenStack Deployment mit Kubernetes Clustern versorgt. Die Hauptherausforderung liegt in der einheitlichen Verwaltung dieser verschiedenen Plattformen und der optimalen Ressourcennutzung bei begrenztem IT-Budget.

Krake schafft eine einheitliche Managementebene und ermöglicht:

– Automatische Verteilung von Entwicklungs- und Testumgebungen

– Lastabhängige Skalierung von Kundenanwendungen

– Nahtlose Wartungsfenster durch automatische Workload-Verlagerung

Messbare Verbesserungen:*

– Steigerung der durchschnittlichen Server-Auslastung von 45% auf 75%

– Reduktion der Verwaltungszeit um 60% durch zentralisiertes Management

– Verkürzung der Bereitstellungszeit für neue Entwicklungsumgebungen von 2 Tagen auf 30 Minuten

– Energieeinsparung von 25% durch optimierte Ressourcenverteilung

– Zero-Downtime bei Wartungsarbeiten durch automatische Workload-Migration

*Fiktive Werte

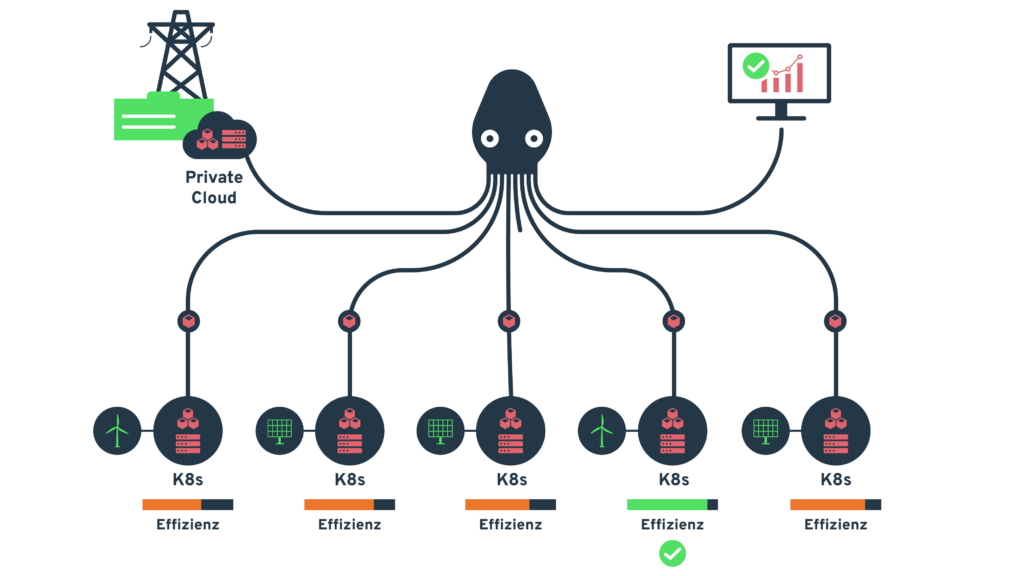

Intelligente Workload-Verteilung beim regionalen Energieversorger

Ein regionaler Energieversorger nutzt Krake zur Orchestrierung seiner hybriden IT-Infrastruktur, die aus OpenStack-basierten Private Clouds und Kubernetes-Clustern an fünf Standorten besteht. Die besondere Herausforderung liegt in der optimalen Nutzung der schwankenden Energieerzeugung aus eigenen Wind- und Solarparks bei gleichzeitiger Gewährleistung der Versorgungssicherheit.

Krake orchestriert die Container-Workloads basierend auf einem mehrdimensionalen Optimierungsmodell:

– Die Verfügbarkeit erneuerbarer Energie wird in Echtzeit mit Latenzanforderungen und Ressourcenbedarf abgewogen

– Nicht-zeitkritische Analysen der Smart-Meter-Daten werden automatisch an Standorte mit Energieüberschuss verlagert

– Kritische Anwendungen wie die Netzüberwachung werden stets innerhalb definierter Latenzgrenzen von maximal 10ms betrieben werden

Messbare Verbesserungen:*

– Steigerung des Anteils erneuerbarer Energien im Rechenzentrumsverbund von 60% auf 85%

– Reduktion der IT-Energiekosten um 45%

– Verringerung der durchschnittlichen Reaktionszeit kritischer Anwendungen um 30%

– Automatisierung von 95% der Workload-Verteilung, die zuvor manuell gesteuert wurde

Durch die zentrale Verwaltungsschnittstelle von Krake konnte das DevOps-Team von einer standortspezifischen auf eine serviceorientierte Organisationsstruktur umgestellt werden, was die Entwicklung neuer Dienste deutlich beschleunigt.

*Fiktive Werte

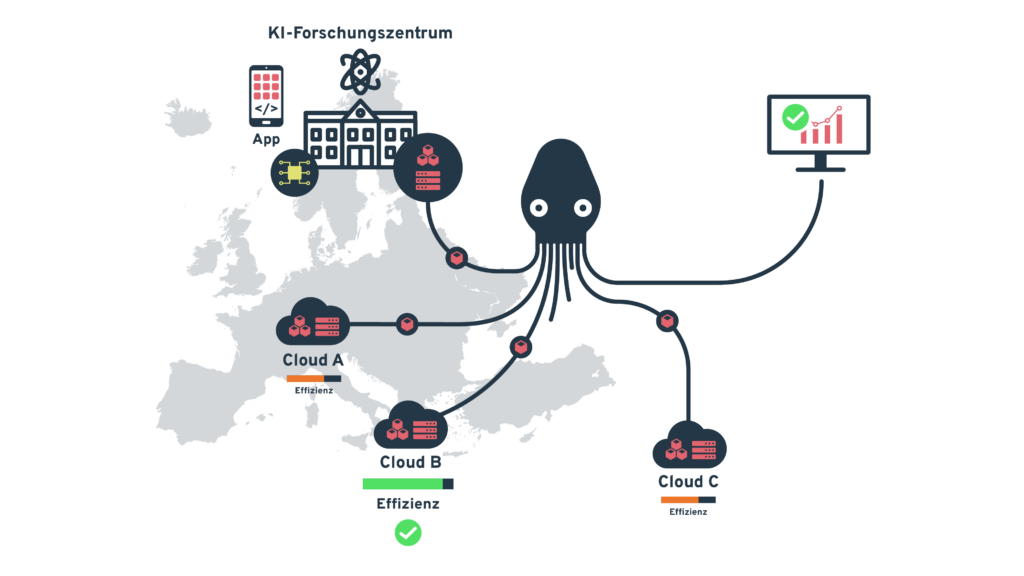

KI-Training auf hybrider Cloud-Infrastruktur in Europa

Ein europäisches KI-Forschungskonsortium nutzt Krake zur Orchestrierung seiner Machine-Learning-Workloads über eine hybride Infrastruktur, die sowohl eigene Rechenzentren, als auch Kubernetes-Cluster mehrerer Cloud-Provider umfasst. Die zentrale Herausforderung besteht in der optimalen Nutzung der unterschiedlichen Preismodelle und Hardware-Ressourcen (spezialisierte GPUs, TPUs, FPGAs) und der Einhaltung von Datenschutzanforderungen.

Krake orchestriert die Workloads basierend auf mehreren Parametern:

– Kosten der verschiedenen Cloud-Provider und Standorte

– Verfügbarkeit spezieller Hardware-Beschleuniger

– Datenschutzanforderungen (z.B. GDPR-konforme Verarbeitung)

– Energie-Effizienz der Standorte

– Netzwerk-Latenz für verteiltes Training

Messbare Verbesserungen:*

– Reduktion der Trainingskosten um 55% durch dynamische Nutzung günstiger Cloud-Ressourcen

– Verkürzung der Trainingszeit komplexer Modelle um 40% durch optimierte Hardware-Zuweisung

– Energieeinsparung von 40% durch Verlagerung von Workloads zu energieeffizienten Standorten

– 100% GDPR-Konformität durch regelbasierte Workload-Verteilung

– Automatisierung von 90% der früher manuellen Scheduling-Entscheidungen

*Fiktive Werte

Unser Open-Source-Projekt Krake wurde mit dem Sächsischen Digitalpreis 2024 in der Kategorie Open-Source ausgezeichnet. Nachdem es von einer Fachjury ausgewählt wurde, setzte sich Krake auch im Publikumsvoting gegen zwei weitere Nominierte durch.

Wir möchten uns an dieser Stelle herzlich bei allen bedanken, die uns beim Voting unterstützt und für Krake gestimmt haben.

(Eine Video-Produktion der Sympathiefilm GmbH)

Krake wird vorgestellt

Krake im Projekt „AI-Sprint“

Im November 2023 fand Krake sein neues Zuhause bei ALASCA – einem gemeinnützigen Verein für die (Weiter)entwicklung betriebsfähiger, offener Cloud-Infrastrukturen. Die Mission von ALASCA dreht sich um die Weiterentwicklung und Bereitstellung von Open-Source Tools, die den Aufbau und Betrieb eigener Cloud-Infrastrukturen nicht nur ermöglichen, sondern auch erleichtern.

Neben der praktischen Entwicklungsarbeit an diesen Projekten versteht sich ALASCA auch als Vermittler von Wissen rund um diese Themen – nicht nur innerhalb des Vereins, sondern auch nach außen hin, wie beispielsweise in Form der ALASCA Tech-Talks.

Mit einer starken, motivierten Community und der geballten Kompetenz der Vereinsmitglieder treibt ALASCA die digitale Souveränität in Deutschland und Europa damit nachhaltig voran – auch in Zusammenarbeit mit weiteren Open-Source-Initiativen und -Communities der digitalen Branche.